Zapraszamy do lektury miesięcznika „Help – jesteśmy razem”.

„Help” wydawany jest dzięki współfinansowaniu ze środków Państwowego Funduszu Rehabilitacji Osób Niepełnosprawnych.

Projekt „HELP – jesteśmy razem – miesięcznik, informacje o świecie dotyku i dźwięku dla osób niewidomych, słabowidzących oraz ich otoczenia” jest dofinansowany ze środków PFRON i ze środków własnych Fundacji Szansa – Jesteśmy Razem.

Dofinansowano ze środków Ministra Kultury i Dziedzictwa Narodowego pochodzących z Funduszu Promocji Kultury.

Zachęcamy do bezpłatnej subskrypcji naszego miesięcznika. Osoby zainteresowane prosimy o wyrażenie chęci otrzymywania newslettera poprzez maila na adres: help@szansadlaniewidomych.org

Nr 102 biuletynu: pdf, doc, rtf, txt

Nr 101 biuletynu: pdf, doc, rtf, txt

Nr 100 biuletynu: pdf, doc, rtf, txt

Nr 99 biuletynu: pdf, doc, rtf, txt

Nr 98 biuletynu: pdf, doc, rtf, txt

Nr 97 biuletynu: pdf, doc, rtf, txt

Nr 96 biuletynu: pdf, doc, rtf, txt

Nr 95 biuletynu: pdf doc, rtf, txt

Nr 94 biuletynu: pdf, doc, rtf, txt

Nr 93 biuletynu: pdf, doc, rtf, txt

Nr 92 biuletynu: pdf, doc, rtf, txt

Nr 91 biuletynu: pdf, doc, rtf, txt

Nr 90 biuletynu: pdf, doc, rtf, txt

Nr 89 biuletynu: pdf, doc, rtf, txt

Nr 88 biuletynu: pdf, doc, rtf, txt

Nr 87 biuletynu: pdf, doc, rtf, txt , audio

Nr 86 biuletynu: pdf, doc, rtf, txt, audio

Nr 85 biuletynu: pdf, doc, rtf, txt, audio

Nr 84 biuletynu: pdf, doc, rtf, txt, audio

Nr 83 biuletynu: pdf, doc, rtf, txt, audio

Nr 82 biuletynu: pdf, doc, rtf, txt, audio

Nr 81 biuletynu: pdf, doc, rtf, txt, audio

Nr 80 biuletynu: pdf, doc, rtf, txt, audio

Nr 79 biuletynu: pdf, doc, rtf, txt, audio

Nr 78 biuletynu: pdf, doc, rtf, txt, audio

Nr 77 biuletynu: pdf, doc, rtf, txt, audio

Nr 76 biuletynu: pdf, doc, rtf, txt, audio

Nr 75 biuletynu: pdf, doc, rtf, txt, audio

Nr 74 biuletynu: pdf, doc, rtf, txt, audio

Nr 73 biuletynu: pdf, doc, rtf, txt, audio

Nr 72 biuletynu: pdf, doc, rtf, txt, audio

Nr 71 biuletynu: pdf, doc, rtf, txt, audio

Nr 70 biuletynu: pdf, doc, rtf, txt

Nr 69 biuletynu: pdf, doc, rtf, txt, audio

Nr 68 biuletynu: pdf, doc, rtf, txt, audio

Nr 67 biuletynu: pdf, doc, rtf, txt, audio

Nr 66 biuletynu: pdf, doc, rtf, txt

Nr 65 biuletynu: pdf, doc, rtf, txt

Nr 64 biuletynu: pdf, doc, rtf, txt

Nr 63 biuletynu: pdf, doc, rtf, txt

Nr 62 biuletynu: pdf, doc, rtf, txt

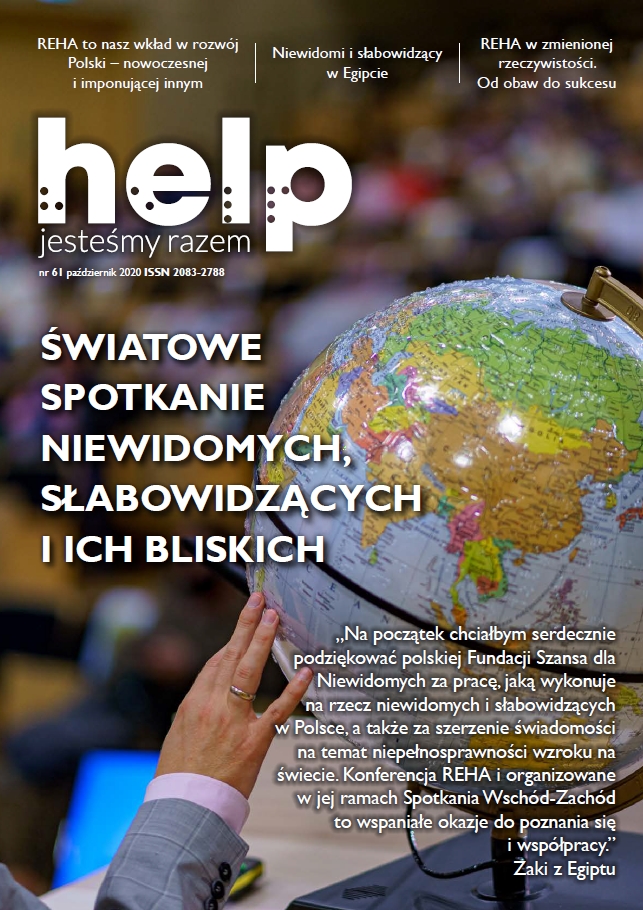

Nr 61 biuletynu: pdf, doc, rtf, txt

Nr 60 biuletynu: pdf, doc, rtf, txt

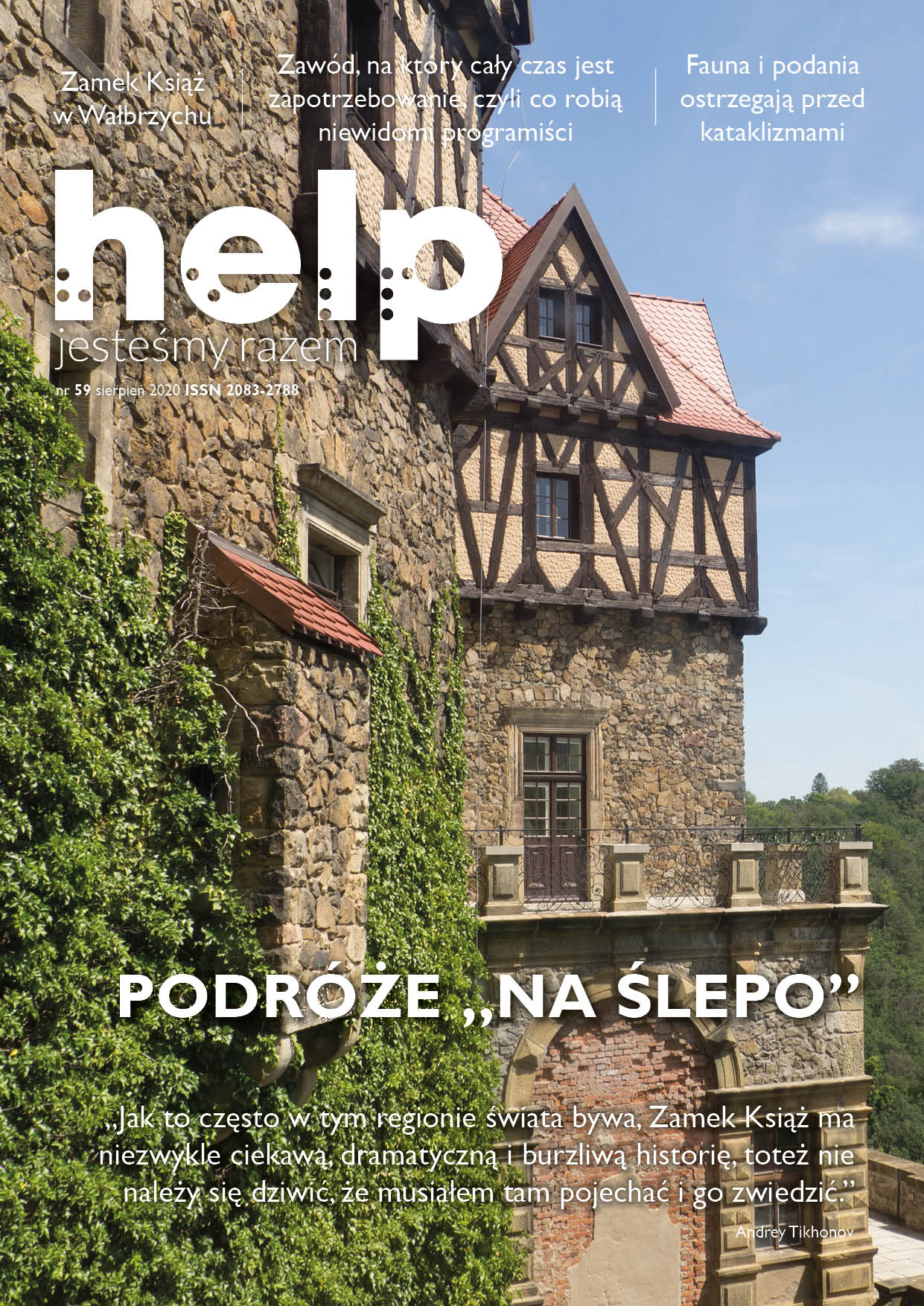

Nr 59 biuletynu: pdf,

doc, rtf, txt

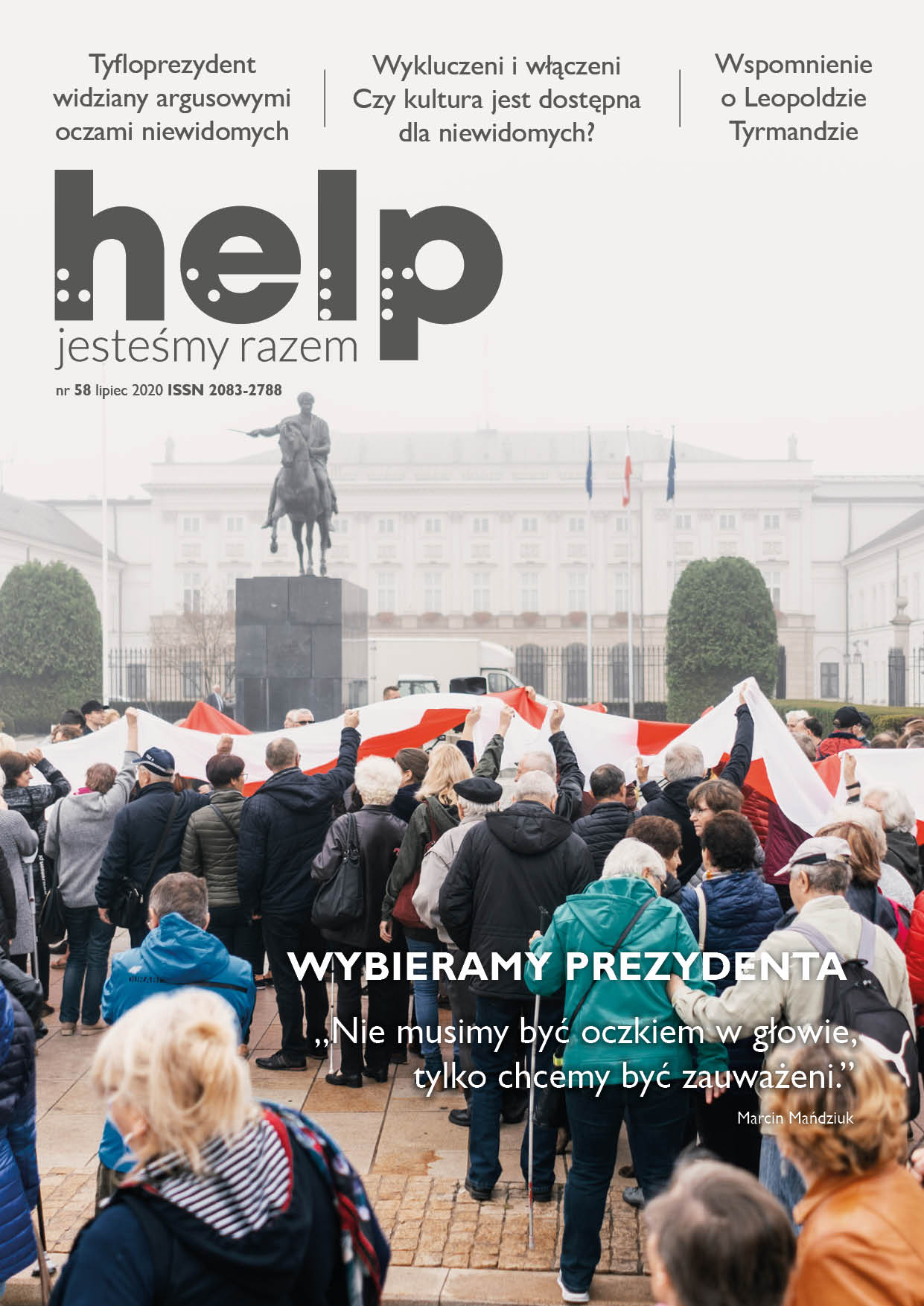

Nr 58 biuletynu: pdf,

doc, rtf, txt

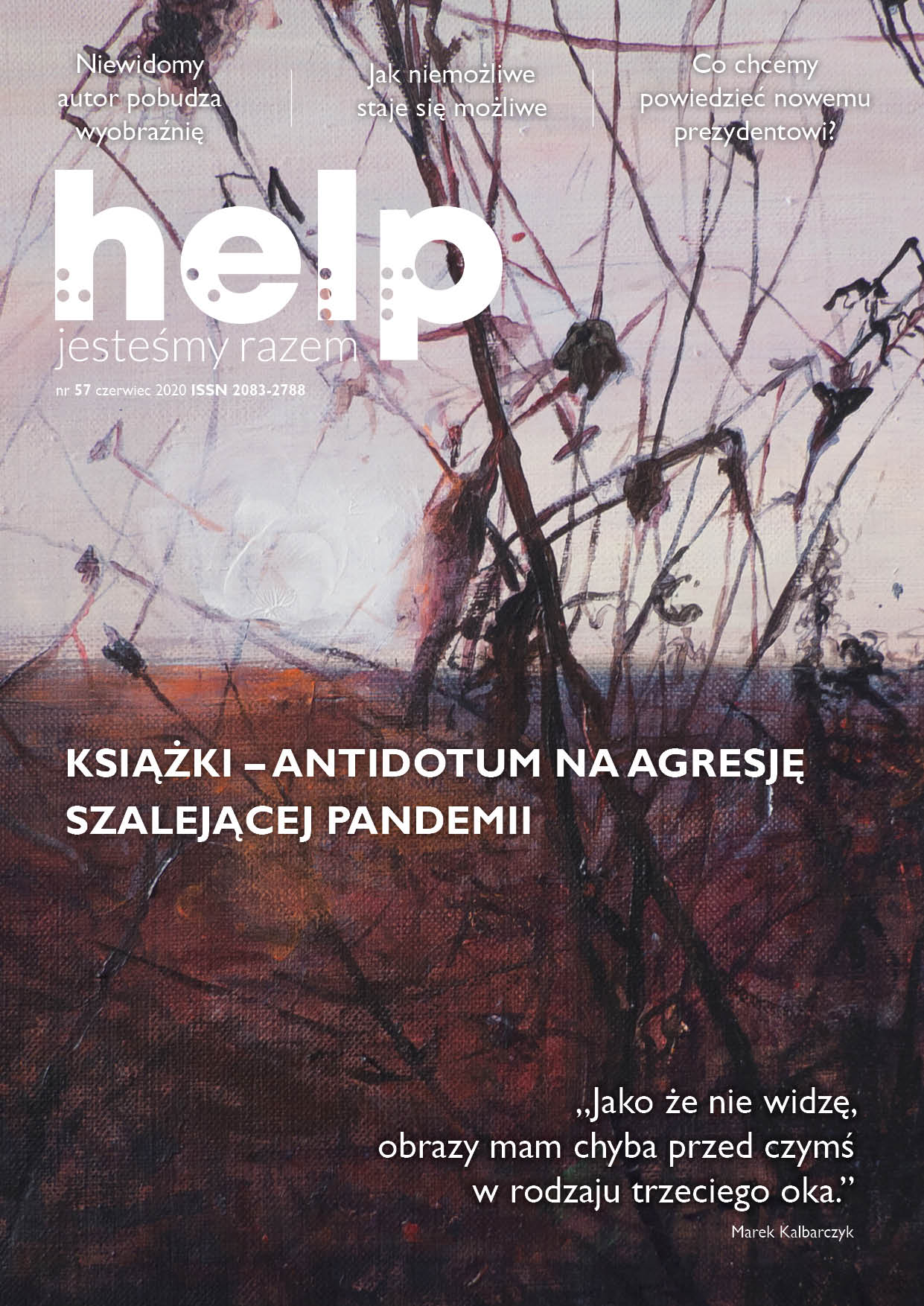

Nr 57 biuletynu: pdf,

doc, rtf, txt

Nr 56 biuletynu: pdf, doc, rtf, txt

Nr 55 biuletynu: pdf, doc, rtf, txt

Nr 54 biuletynu: pdf, doc, rtf, txt

Nr 53 biuletynu: pdf, doc, rtf, txt

Nr 52 biuletynu: pdf, doc, rtf, txt

Nr 51 biuletynu: pdf, doc, rtf, txt

Nr 50 biuletynu: pdf, doc, rtf, txt

Nr 49 biuletynu: pdf, doc, rtf, txt

Nr 48 biuletynu: pdf, doc, rtf, txt

Nr 47 biuletynu: pdf, doc, rtf, txt

Nr 46 biuletynu: pdf, doc, rtf, txt

Nr 45 biuletynu: pdf, doc, rtf, txt

Nr 44 biuletynu: pdf, doc, rtf, txt

Nr 43 biuletynu: pdf, docx, rtf, txt

Nr 42 biuletynu: pdf, docx, rtf, txt

Nr 41 biuletynu: pdf, docx, rtf, txt

Nr 40 biuletynu: pdf, docx, rtf, txt

Nr 39 biuletynu: pdf, docx, rtf, txt

Nr 38 biuletynu: pdf, doc, rtf, txt

Nr 37 biuletynu: wersja pdf, wersja rtf, wersja txt, wersja doxc

Nr 36 biuletynu: wersja pdf, wersja rtf, wersja txt

Nr 35 biuletynu: wersja pdf, wersja rtf, wersja txt

Nr 34 biuletynu: wersja pdf, wersja rtf, wersja txt

Nr 33 biuletynu: wersja pdf, wersja rtf, wersja txt

Nr 32 biuletynu: wersja pdf, wersja rtf, wersja txt

Nr 31 biuletynu: wersja pdf, wersja rtf, wersja txt

Nr 30 biuletynu: wersja pdf, wersja rtf, wersja txt

Nr 29 biuletynu: wersja pdf, wersja rtf, wersja txt

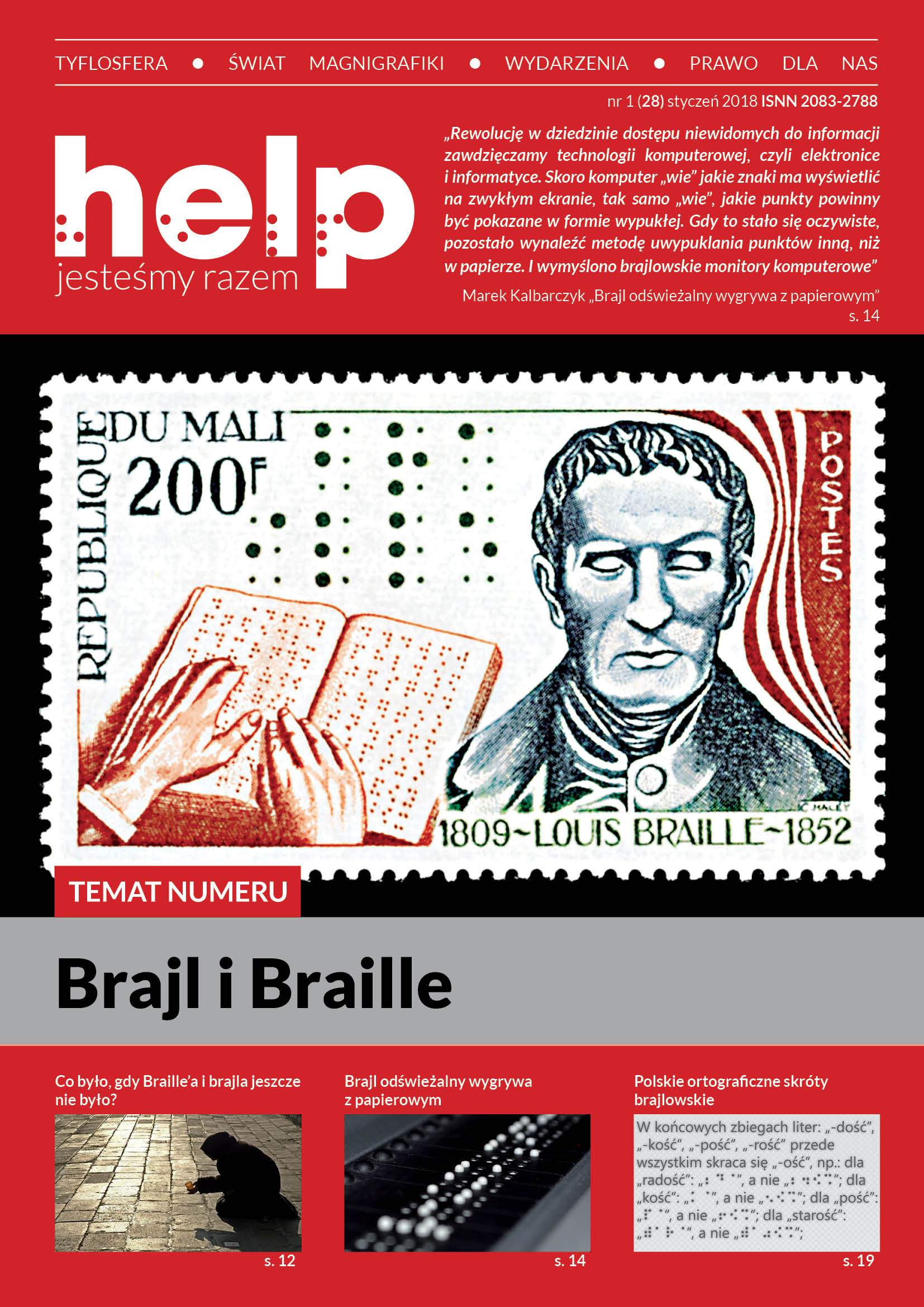

Nr 28 biuletynu: wersja pdf, wersja rtf, wersja txt

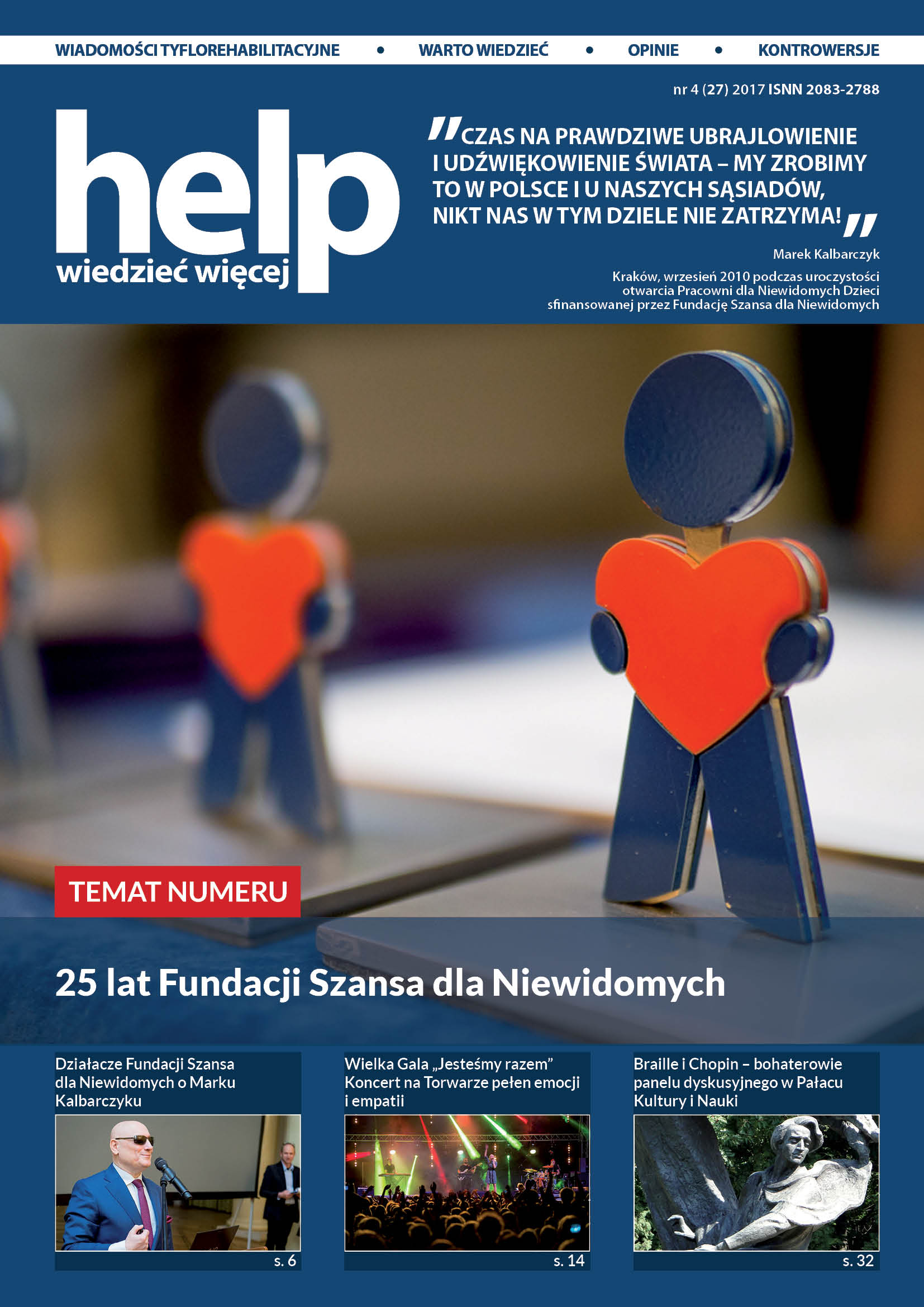

Nr 27 biuletynu: wersja pdf, wersja rtf, wersja txt

Nr 26 biuletynu: wersja pdf, wersja txt, wersja rtf

Nr 25 biuletynu: wersja pdf, wersja txt, wersja rtf

Nr 24 biuletynu: wersja pdf, wersja txt, wersja rtf

Nr 23 biuletynu: wersja pdf, wersja txt, wersja rtf

Nr 22 biuletynu: wersja pdf, wersja txt, wersja rtf

Nr 21 biuletynu: wersja pdf, wersja txt, wersja rtf

Nr 20 biuletynu: wersja pdf, wersja txt, wersja rtf

Nr 19 biuletynu: wersja pdf, wersja txt, wersja rtf

Nr 18 biuletynu: wersja pdf, wersja txt, wersja rtf

Nr 17 biuletynu: wersja pdf, wersja txt, wersja rtf

Nr 16 biuletynu: wersja pdf, wersja txt, wersja doc, wersja rtf

Wydanie specjalne: wersja pdf, wersja txt, wersja doc, wersja rtf

Nr 15 biuletynu: wersja pdf, wersja rtf, wersja doc, wersja txt

Nr 14 biuletynu: wersja pdf, wersja rtf, wersja txt

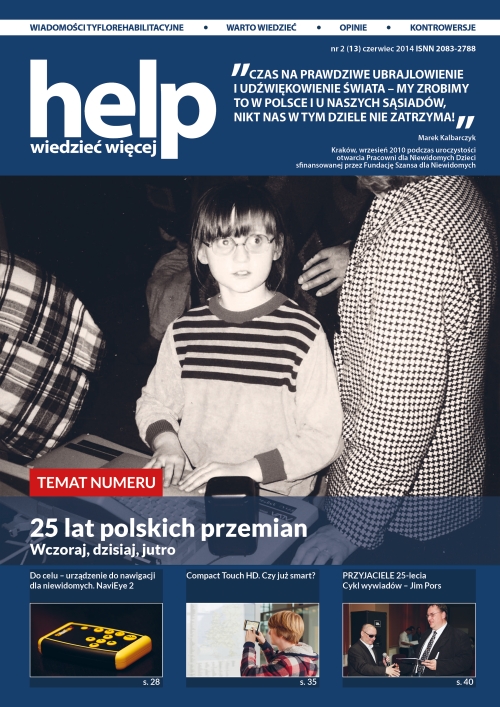

Nr 13 biuletynu: wersja pdf, wersja rtf, wersja txt

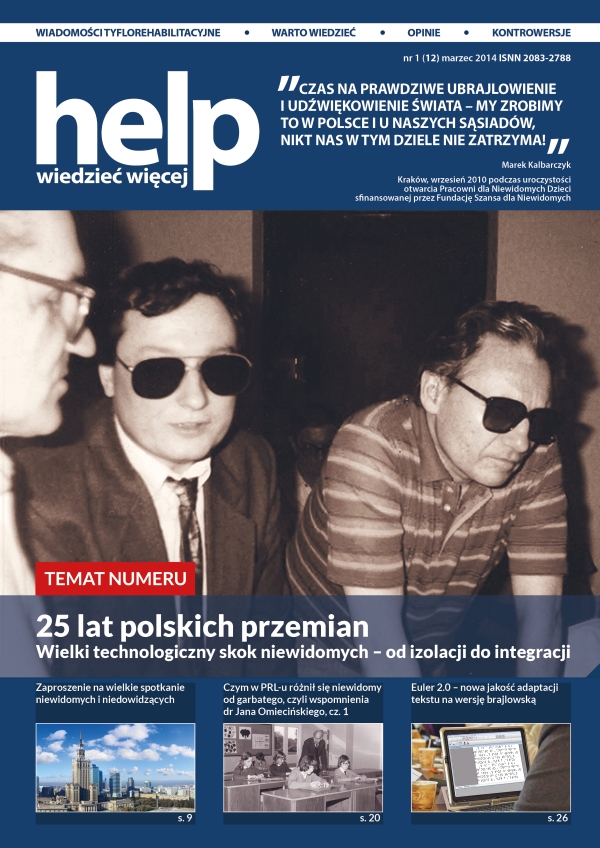

Nr 12 biuletynu: wersja pdf, wersja rtf, wersja txt

Nr 11 biuletynu: wersja pdf, wersja rtf, wersja txt

Nr 10 biuletynu: wersja pdf, wersja rtf, wersja txt

Nr 9 biuletynu: wersja pdf, wersja rtf, wersja txt

Nr 8 biuletynu: wersja pdf, wersja rtf, wersja txt

Nr 7 biuletynu: wersja pdf, wersja rtf, wersja txt

Nr 6 biuletynu: wersja pdf, wersja doc, wersja rtf, wersja txt

Nr 5 biuletynu: wersja pdf, wersja doc, wersja rtf, wersja txt

Nr 4 biuletynu: wersja pdf, wersja doc, wersja rtf, wersja txt

Nr 3 biuletynu: wersja pdf, wersja HTML, wersja rtf, wersja txt

Nr 2 biuletynu: wersja pdf, wersja HTML, wersja doc, wersja rtf, wersja txt

Nr 1 biuletynu: wersja pdf, wersja HTML, wersja rtf, wersja txt

Numer historyczny Grudzień ’92:

Publikacja dofinansowana ze środków Państwowego Funduszu Rehabilitacji Osób Niepełnosprawnych